Hace unos días asistí a una webinar de Databricks en la que hablaron acerca de cómo integrar los dos mundos de analítica, el tradicional Business Intelligence y la parte más ligada a Machine Learning y la Ciencia de Datos.

Como sabemos, si a un experto en Inteligencia de Negocio le preguntas por: Data Warehouse, Factoría de Información Corporativa, Data Marts, Cubos, etc. Sin duda, la respuesta será muy completa e incluso te podrá dar multitud de casos de éxito en los que ha trabajado implementando dichas soluciones. Sin embargo, desde hace unos años las necesidades empresariales de análisis en tiempo real de la información, han provocado que se añadan nuevo términos al proceso de generación de conocimiento. Streaming, Event Hubs, Data Lake, Real Time, Lambda, etc.

Sin embargo, desde hace unos años las necesidades empresariales de análisis en tiempo real de la información, han provocado que se añadan nuevo términos al proceso de generación de conocimiento. Streaming, Event Hubs, Data Lake, Real Time, Lambda, etc.

Y sobre todo con la aparición de la “profesión más sexy del siglo XXI”, el Científico de Datos, el conjunto de nuevas palabras vinculadas a la analítica ha continuado creciendo: DataFrames, Hiperparámetros, Redes Neuronales, Modelos, Algoritmos, Clúster, etc.

Esta situación, con necesidades analíticas tan dispares, supone un problema para las compañías a la hora de manejar de una manera sencilla y eficaz los datos. Si bien, el coste de almacenamiento de datos, ha descendido con las nuevas herramientas en la nube, duplicar servicios para su tratamiento y gestión, puede engordar la cuenta a final de mes. Es por ello, que se requiere una gestión única del dato en el entorno empresarial, para aprovechar la mejor arquitectura y permitir la optimización de recursos corporativos en la generación de conocimiento.

Esta situación, con necesidades analíticas tan dispares, supone un problema para las compañías a la hora de manejar de una manera sencilla y eficaz los datos. Si bien, el coste de almacenamiento de datos, ha descendido con las nuevas herramientas en la nube, duplicar servicios para su tratamiento y gestión, puede engordar la cuenta a final de mes. Es por ello, que se requiere una gestión única del dato en el entorno empresarial, para aprovechar la mejor arquitectura y permitir la optimización de recursos corporativos en la generación de conocimiento.

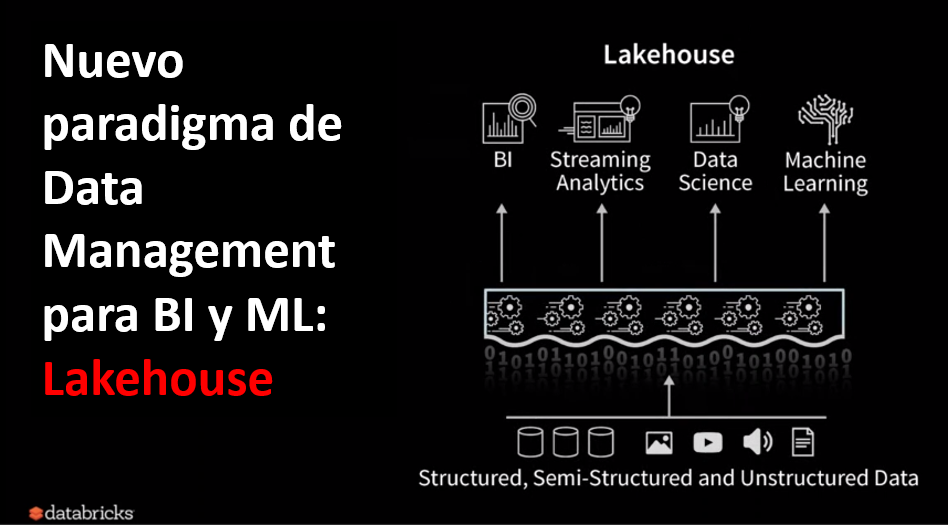

¿Cómo hacer esto? Buscando la manera de integrar el BI tradicional con la Analítica Avanzada en un único entorno. Por eso es por lo que hablamos de Lakehouse, viene a quedarse con lo bueno de ambos Mundos. Para ello, se desarrolla un nuevo paradigma de desarrollo de arquitectura. Lo que denominan Lakehouse.

Para ello, se desarrolla un nuevo paradigma de desarrollo de arquitectura. Lo que denominan Lakehouse.

Pero, técnicamente ¿cómo soluciona Databricks los problemas que presenta esta arquitectura?

En primer lugar, usando Spark como el motor principal de unificación, ya que permite integrarse con multitud de herramientas ETL, Data Warehouse, además de soportar el procesamiento en streaming, grafos e incorporar librerías para Machine Learning y Deep Learning.

Y en segundo lugar, unificando el servicio de datos tanto para BI como para ML. Ya que Delta Lake asegura la confiabilidad del dato, ya que permite transacciones ACID, unifica procesos Batch y Streaming, aplica el schema, además de permitir Viaje de Tiempo y transmisión por secuencias, entre otras características.

CONCLUSIÓN

El mundo empresarial precisa cubrir nuevas necesidades en cuanto a analítica avanzada, lo cual representa un desafío que obliga a organizaciones y personas a dar lo mejor de si mismo. La aparición de este nuevo paradigma por parte de Databricks no hace más que ahondar en la clara obligación de evolución y mejora continua. Representa un importante salto hacia adelante por combinar en una arquitectura, el procesamiento de todo tipo de datos tanto en Streaming como en Batch, permitiendo integrar modelos de inteligencia artificial, para obtener un Reporting completo.

Si hace unos meses presentaron Delta Lake y representó una mejora sustancial frente a parquet u otros sistemas de almacenamiento, hoy con esta nueva aportación creo que Databricks se posiciona como la solución de referencia en la Analítica Avanzada a día de hoy.

NOTA: Importante recordar que Databricks permite la completa integración de sus productos con las nubes de Azure y AWS.

Fuentes | Introducción a Delta Lake – Microsoft, Marzo 2020.

Imagen 1, 2 | Prakach Chockalingam, James Nguyen. “Introducing Databricks Ingest”. March, 2020.